Методы одномерной безусловной оптимизации с использованием производных.

Методы с использованием производных:

1.3. Ньютоновские методы:

2.1.1 Ньютона-Рафсона:

Прямые методы многомерной безусловной оптимизации.

Прямые методы:

1. Рельеф функции – линии уровня:

• котловинный;

• овражный;

• неупорядоченный.

2. Метод покоординатного спуска (метод Гаусса);

3. Метод оврагов.

Многомерная безусловная оптимизация по методу градиентного спуска.

Методы первого и второго порядков:

1. Градиентные методы:

1.1. Метод градиентного спуска:

1.2. Метод Ньютона разложение в ряд Тейлора.

Многомерная безусловная оптимизация по методу Ньютона.

Метод Ньютона разложение в ряд Тейлора:

Недостатки:

• не сходится глобально;

• требует аналитического знания 1 и 2 производных;

• на каждом шаге нужно решать систему уравнений;

• может искать седловые точки.

Многомерная безусловная оптимизация по методу Маркварта.

Метод Маркварта – комбинация метода градиентного спуска и Ньютона:

Условная оптимизация с ограничениями равенствами.

Условная оптимизация заданной целевой функции заменяется безусловной оптимизацией вновь создаваемой функции, имеющей экстремум в той же точке.

Задачи с ограничениями в виде равенств

Метод множителей Лагранжа для снятия условия.

Условная оптимизация с ограничениями неравенствами.

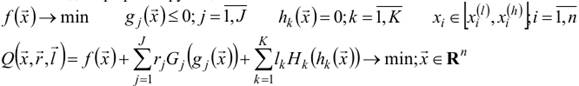

Задача с ограничениями в виде неравенств:

1. Метод функций Лагранжа.

|

|

|

Ограничения применимости – условие регулярности ограничивающих функций в точке х:

• количество активных ограничений в точке x меньше n

• градиенты акивных ограничений gj(х) в точке x не коллинеарны.

2. Метод штрафных функций.

Метод внешних штрафных функций:

Метод барьерных функций:

Метод факторов:

Алгоритм простого случайного поиска.

1. Простой случайный поиск.

Генерируются случайные числа

с равномерным законом распределения.

•

• Определяется начальное приближение х0, а дальше осуществляется один из детерминированных методов.

2. Ненаправленный случайный поиск – последующие испытания не зависят от результатов

предыдущих.

Минус: Малая скорость сходимости.

Плюс: Возможность поиска глобального экстремума решения

Алгоритм направленного случайного поиска.

Направленный случайный поиск – результаты проведённых испытаний используются для формирования последующих.

1. Алгоритм парной пробы.

В текущей точке xk по равномерному закону генерируется случайный вектор

2. Алгоритм наилучшей пробы.

В текущей точке xk по равномерному закону генерируется M случайных векторов:

3. Метод статического градиента.

|

|

|

4. Алгоритмы наилучшей пробы с направляющим гиперквадратом.

Берётся гиперквадрат заданный векторами ak и bk. В его области генерируются по равномерному закону генерируется M случайных значений:

Дата добавления: 2019-02-12; просмотров: 354; Мы поможем в написании вашей работы! |

Мы поможем в написании ваших работ!