Спектральные представления случайных процессов. Теорема Виннера-Хинчина.

Если какой-либо сигнал представлен в виде суммы гармонических колебаний с различными частотами, то говорят что осуществлено спектральное разложение этого сигнала. Отдельные гармонические компоненты сигнала образуют его спектр.

Теорема Винера-Хинчина. формулируется так: «Функция автокорреляции и энергетический спектр стационарного случайного процесса, имеющего нулевое математическое ожидание, связаны между собой преобразованием Фурье».

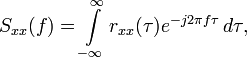

Непрерывный случай:

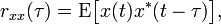

где

есть автокорреляционная функция, определённая через математическое ожидание, и где Sxx(f) — спектральная плотность мощности функции

есть автокорреляционная функция, определённая через математическое ожидание, и где Sxx(f) — спектральная плотность мощности функции  .

.

Отметим, что автокорреляционная функция определена через математическое ожидание от произведения и что преобразования Фурье от  не существует в общем случае, так как стационарные случайные функции не интегрируемы в квадратичном.

не существует в общем случае, так как стационарные случайные функции не интегрируемы в квадратичном.

Звёздочка означает комплексное сопряжение, оно может быть опущено, если случайный процесс вещественный.

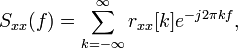

Дискретный случай:

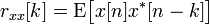

где

корреляционная функция,

корреляционная функция,

и где

Sxx(f) — спектральная плотность мощности с дискретными значениями  . Являясь упорядоченной по дискретным отсчётам времени, спектральная плотность — периодическая функция в частотной области.

. Являясь упорядоченной по дискретным отсчётам времени, спектральная плотность — периодическая функция в частотной области.

Теория информации. Определения и свойства энтропии.

Теория информации (математическая теория связи) — раздел прикладной математики, аксиоматически определяющий понятие информации, её свойства и устанавливающий предельные соотношения для систем передачи данных. Как и любая математическая теория, оперирует с математическими моделями, а не с реальными физическими объектами (источниками и каналами связи). Использует, математический аппарат теории вероятностей и математической статистики.

|

|

|

Основные разделы теории информации — кодирование источника (сжимающее кодирование) и канальное (помехоустойчивое) кодирование. Теория информации тесно связана с криптографией и другими смежными дисциплинами.

В теории информации ЭНТРОПИЯ — это мера неопределённости какого-либо опыта (испытания), который может иметь разные исходы, а значит и количество информации;

Энтропия является мерой неопределенности опыта, в котором проявляются случайные события, и равна средней неопределенности всех возможных его исходов.

СВОЙСТВА ЭНТРОПИИ.

1. H = 0 только в двух случаях:

какая-либо из p(Aj) = 1; однако, при этом следует, что все остальные p(Ai) = 0 (i  j), т.е. реализуется ситуация, когда один из исходов является достоверным (и общий итог опыта перестает быть случайным);

j), т.е. реализуется ситуация, когда один из исходов является достоверным (и общий итог опыта перестает быть случайным);

все p(Ai) = 0, т.е. никакие из рассматриваемых исходов опыта невозможны, поскольку нетрудно показать, что:

|

|

|

Во всех остальных случаях, очевидно, что H > 0.

2. для двух независимых опытов  и

и

(1.5)

(1.5)

Энтропия сложного опыта, состоящего из нескольких независимых, равна сумме энтропий отдельных опытов.

Пусть опыт  имеет n исходов A1, A2, ..., An, которые реализуются с вероятностями p(A1), p(A2), ..., p(An), а событие

имеет n исходов A1, A2, ..., An, которые реализуются с вероятностями p(A1), p(A2), ..., p(An), а событие  – m исходов B1, B2, ..., Bm с вероятностями p(B1), p(B2), ..., p(Bm). Сложный опыт

– m исходов B1, B2, ..., Bm с вероятностями p(B1), p(B2), ..., p(Bm). Сложный опыт  имеет n ·mисходов типа AiBj (i=1...n, j=1...m). Следовательно:

имеет n ·mисходов типа AiBj (i=1...n, j=1...m). Следовательно:

(1.6)

(1.6)

Поскольку  и

и  – независимы, то независимыми окажутся события в любой паре Ai

– независимы, то независимыми окажутся события в любой паре Ai  Bj. Тогда:

Bj. Тогда:

В слагаемых произведено изменение порядка суммирования в соответствии со значениями индексов. Далее, по условию нормировки:

а из (1.4)

Окончательно имеем:

что и требовалось доказать.

Пусть имеется два опыта с одинаковым числом исходов n, но в одном случае они равновероятны, а в другом – нет. Каково соотношение энтропий опытов? Примем без доказательства следующее утверждение:  (1.7)

(1.7)

При прочих равных условиях наибольшую энтропию имеет опыт с равновероятными исходами.

Другими словами, энтропия максимальна в опытах, где все исходы равновероятны.

Дата добавления: 2018-02-18; просмотров: 1557; Мы поможем в написании вашей работы! |

Мы поможем в написании ваших работ!