Области применения персептронов

С появлением алгоритма обратного распространения ошибки начался период широкого практического применения нейросетевых технологий для решения самых разнообразных задач. С помощью многослойного персептрона стало возможным строить математические модели, выполняющие сложные многомерные отображения входного вектора X параметров на выходной вектор Y.

Персептроны открыли иной подход к методике построения математических моделей. Появилась возможность, исходя из одного только эмпирического опыта (обучающей выборки), строить математические модели, позволяющие эффективно использовать их для решения широкого круга практических задач.

Перечислим наиболее известные практические задачи, в которых нашли применение нейронные сети.

· Диагностика в медицине.

· Диагностика неисправностей сложных технических устройств.

· Нейросетевой детектор лжи.

· Нейросеть-антихакер.

· Нейросети в банковском деле.

· Прогнозирование валютных курсов и котировок ценных бумаг.

· Задачи оптимизации, прогнозирования, управления, распознавания и классификации.

Проектирование и обучение персептронов

При моделировании или при создании математической модели функционирования некоторого объекта важными являются следующие положения.

Подавляющее большинство всех прикладных задач, решаемых методом математического моделирования, сводится к нахождению некоторой сложной функции, осуществляющей многомерное преобразование вектора входных параметров Xна вектор выходных параметров Y. Универсальным инструментом построения такой функции являются нейросетевые технологии.

|

|

|

Всегда ли можно построить нейросеть, выполняющую преобразование, заданное любой обучающей выборкой, и каким требованиям эта нейросеть должна удовлетворять?

Ответ на этот вопрос дали исследования, проведенные зарубежными и русскими учеными [1, 2].

В частности было доказано, что для любого множества пар отличных между собой входных и выходных векторов произвольной размерности ( Xq, Dq), q = 1,…, P существует двухслойный персептрон с сигмоидальными активационными функциями и с конечным числом нейронов, который для каждого входного вектора Xq формирует соответствующий ему выходной вектор Dq. Таким образом, была доказана принципиальная возможность построения нейросети, выполняющей преобразование, заданное любой обучающей выборкой различающихся между собой примеров, и установлено, что такой универсальной нейросетью является двухслойный персептрон с конечным числом нейронов и сигмоидными активационными функциями.

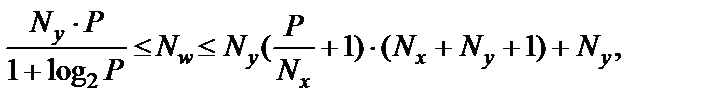

Для определения необходимого числа нейронов в скрытых слоях персептрона была предложена формула [1]:

|

|

|

(27)

(27)

где Ny – размерность выходного сигнала; P – число элементов обучающей выборки; Nw – необходимое число синаптических весов; Nx – размерность входного сигнала.

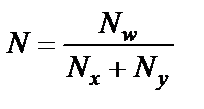

Оценив с помощью этой формулы необходимое число синаптических весов, можно рассчитать число нейронов в скрытых слоях. Например, число нейронов скрытого слоя двухслойного персептрона равно:

. (28)

. (28)

Строгой теории выбора оптимального числа скрытых слоев персептронов пока нет. На практике же чаще всего используются персептроны, имеющие один или два скрытых слоя, причем число нейронов в скрытых слоях обычно колеблется от Nxдо 3Nx.

При проектировании персептрона необходимо понимать, что персептрон должен не только правильно реагировать на обучающие примеры, но и уметь обобщать приобретенные знания, т.е. правильно реагировать на случаи, которых в обучающей выборке не было. Чтобы оценить способность сети к обобщению, помимо обучающей выборки примеров (X;D) в рассмотрение вводят некоторое количество тестовых примеров (XT;DT), которые относятся к той же предметной области, но в процессе обучения не участвуют. Среднеквадратичная погрешность персептрона, вычисленная на обучающей выборке(X;D), называется погрешностью обучения, а вычисленная на тестовой выборке (XT;DT) – погрешностью обобщения. При увеличении числа нейронов внутренних слоев персептрона N погрешность обучения обычно падает, тогда как погрешность обобщения сначала падает, а затем, начиная с некоторого оптимального значения N = N0, возрастает.

|

|

|

Свойство нейросети терять способность к обобщению при чрезмерном увеличении числа ее синаптических связей называют переобучением.

Таким образом, при проектировании персептронов существует проблема выбора необходимого числа нейронов. Число нейронов входного слоя персептрона должно совпадать с размерностью вектора входных параметров X, который определен условиями решаемой задачи. Число нейронов выходного слоя должно совпадать с размерностью выходного вектора Y, что также определено условиями задачи. Число нейронов в скрытых слоях может быть приближенно оценено по формулам (27), (28), однако его желательно оптимизировать для каждой конкретной задачи [2].

Проблемы обучения

Как было показано ранее, все алгоритмы обучения основываются на поиске минимума ошибки для обучающих примеров путем подстройки весовых коэффициентов. В основе большинства алгоритмов лежит метод градиентного спуска и его модификации [2, 4].

|

|

|

Основная проблема обучения персептронов состоит в том, что поверхность функции ошибок обычно имеет очень сложную форму с множеством локальных минимумов. В связи с этим актуальным является развитие методов глобальной оптимизации, т.е. таких, которые позволяют найти глобальный минимум многоэкстремальной целевой функции. Среди множества подходов наиболее успешным признается идея генетических алгоритмов. Эта идея, впервые предложенная Дж. Холландом в 1970-х гг., состоит в имитации природных оптимизационных процессов, происходящих при эволюции живых организмов. Генетический алгоритм подробно рассматривается в следующем разделе.

Дата добавления: 2019-11-16; просмотров: 704; Мы поможем в написании вашей работы! |

Мы поможем в написании ваших работ!