Меры близости (удаленности) объектов

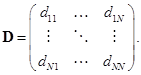

Матрица близостей (удаленностей) задает отношение "объект–объект" и представляет собой квадратную симметричную матрицу N´N с неотрицательными элементами

Элементы dij являются значениями некоторой меры близости (удаленности) между объектами xi и xj. Чаще в анализе данных используются меры удаленности. К этим мерам предъявляются следующие требования:

1. Максимальное сходство объекта с самим собой –

2. Требование симметрии –

3. Выполнение неравенства треугольника –

Последнее требование предъявляется к матрицам расстояний (диагональные элементы должны быть равны нулю). Матрица D, удовлетворяющая перечисленным трем требованиям, допускает толкование структуры взаимоотношений объектов как некоторой геометрической конфигурации точек в многомерном пространстве признаков.

Приведем наиболее распространенные меры расстояния между объектами xi и xj.

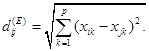

3) Евклидово расстояние –

Эта мера может применяться для вычисления расстояния между объектами, описанными количественными, качественными и бинарными признаками. Ее использование целесообразно, когда признаки однородны по смысловой нагрузке и одинаково важны для решаемой задачи.

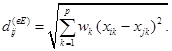

2) Взвешенное евклидово расстояние –

Данную меру используют, когда необходимо количественно выразить важность каких-либо признаков или выровнять масштабы неоднородных признаков.

|

|

|

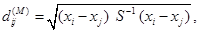

3) Расстояние Махаланобиса –

где S – ковариационная матрица генеральной совокупности, из которой извлечены объекты xi и xj.

Эта мера применяется при сильной зависимости и неоднородности исследуемых признаков, так она инвариантна к линейным преобразованиям пространства признаков (изменению масштаба и повороту осей).

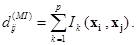

4) Расстояние Минковского –

Это расстояние еще называют "городской метрикой", поскольку в данном случае расстояние между точками определяется аналогично расстоянию вдоль взаимно перпендикулярных улиц городских кварталов /Александров В.В. и др, 1990/. Городская метрика применяется для измерения расстояния между объектами, описанными порядковыми признаками. Ik(xi, xj) равно разнице градаций по k‑му признаку у сравниваемых объектов xi и xj.

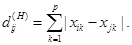

5) Расстояние Хэмминга –

Данная мера наиболее часто используется для определения различий между объектами, задаваемыми дихотомическими признаками, и интерпретируется как число несовпадений значений признаков у объектов xi и xj. Для дихотомических признаков она соответствует квадрату евклидова расстояния. Так же как и для евклидова расстояния может применяться взвешенное расстояние Хэмминга.

|

|

|

6) Другие меры близости для дихотомических признаков.

Эти меры близости обычно основаны на подсчете числа нулевых или единичных компонент признаков, совпавших или не совпавших на объектах xi и xj, и придании этому числу различной степени важности. Подробно указанные меры рассматриваются в /Елисеева И.И. и др., 1977; Житков Г.Н., 1970/.

Представление информации о геометрической структуре многомерных данных посредством матриц связей признаков S и близостей (удаленностей) объектов D служит промежуточным звеном для применения различных методов анализа этих данных, которые будут использоваться в следующих разделах.

Литература

Айвазян С. А., Бухштабер В. М., Енюков И. С., Мешалкин Л. Д. Прикладная статистика: Классификация и снижение размерности. – М.: Финансы и статистика, 1989.

Айвазян С.А., Енюков И.С., Мешалкин Л.Д. Прикладная статистика. Основы моделирования и первичная обработка данных. – М.: Финансы и статистика, 1983.

Александров В.В., Алексеев А.И., Горский Н.Д. Анализ данных на ЭВМ (на примере системы СИТО). – М.: Финансы и статистика, 1990.

Гик Дж., ван. Прикладная общая теория систем. – М.: Мир, 1981.

Гласс Дж., Стэнли Дж. Статистические методы в педагогике и психологии. – М.: Прогресс, 1976.

|

|

|

Дюк В.А. Data Mining – интеллектуальный анализ данных/Byte (Россия), № 9, 1999, с. 18–24.

Дюк В.А. Обработка данных на ПК в примерах. – СПб: Питер, 1997.

Дюк В.А. Компьютерная психодиагностика. – СПб: "Братство", 1994.

Елисеева И.И., Рукавишников В.О. Группировка, корреляция, распознавание образов (Статистические методы классификации и измерения связи). – М.: Статистика, 1977.

Житков Г.Н. Некоторые методы автоматической классификации //Структурные методы опознавания и автоматическое чтение. М.: ВИНИТИ, 1970. – С. 68–85.

Кендалл М. Методы ранговой корреляции. – М.: Статистика, 1974.

Киселев М., Соломатин Е.. Средства добычи знаний в бизнесе и финансах. – Открытые системы, № 4, 1997, с. 41–44.

Кречетов Н.. Продукты для интеллектуального анализа данных. – Рынок программных средств, № 14–15, 1997, c. 32–39.

Никифоров А.М., Фазылов Ш.Х. Методы и алгоритмы преобразования типов признаков в задачах анализа данных. – Ташкент: Фан, 1988.

Статистические методы анализа информации в социологических исследованиях // под ред. Осипова Г. В. –М.: Наука, 1979.

Boulding K. E. General Systems Theory – The Skeleton of Science//Management Science, 2, 1956.

Fix E., Hodges J. L. Discriminatory analysis, nonparametric discrimination USA School of Medicine. – Texas: Rendolph Field, 1951–1952.

|

|

|

Glass G. V. Note on rank-biserial correlation//Educational and Psychological Measurement, 26, 1966. – P. 332-337.

Knowledge Discovery Through Data Mining: What Is Knowledge Discovery? – Tandem Computers Inc., 1996.

Small R. D. Интеллектуальный анализ данных: мифы и факты//InfoWorld, 1997, № 22–23. – С. 38–39.

Дата добавления: 2021-03-18; просмотров: 178; Мы поможем в написании вашей работы! |

Мы поможем в написании ваших работ!