Нейронная сеть прямого распространения

МИНОБРНАУКИ РФ

Федеральное государственное автономное образовательное учреждение высшего образования

Севастопольский государственный университет

ЕТОДИЧЕСКИЕ УКАЗАНИЯ

Изучение алгоритмов обучения нейронных

Сетей прямого распространения

к проведению лабораторных занятий

По дисциплине

Нейросетевое управление

для подготовки студентов по направлению

№ 27.03.04 – «Управление в технических системах»

Севастополь

2019

СОДЕРЖАНИЕ

Введение 4

1. Краткие теоретические сведения 4

1.1. Персептрон Розенблатта 4

1.2. Линейная нейронная сеть 5

1.3. Нейронная сеть прямого распространения с одним скрытым слоем 6

2. Порядок выполнения и задание на работу 7

Содержание отчёта по работе 8

|

|

|

Библиографический список 8

ВВЕДЕНИЕ

Цель работы: Изучение и сравнительный анализ алгоритмов обучения нейронных сетей (НС) прямого распространения.

Существует множество различных типов (архитектур) НС и алгоритмов их обучения. Первый шаг в проектировании НС состоит в выборе ее архитектуры, который, в значительной степени, определяется решаемой задачи. В [2] приведено описание порядка двадцати типов. Во многих случаях, выбор НС прямого распространения может оказаться наиболее предпочтительным. После того, как соответствующий выбор сделан, определяется количество входов, выходов, число скрытых слоев, вид функций активаций сети в соответствии с характером рассматриваемой задачи. Следующий шаг состоит в обучении НС желаемому поведению. Для этого используется так называемая обучающая выборка или учитель. Учитель - это либо математическая функция, либо лицо, которое оценивает качество поведения нейронной сети. Поскольку нейронные сети в основном используются в сложных применениях, где нет хороших математических моделей, то обучение, производится с помощью обучающей выборки, то есть эталонных пар <входы-выходы>. После завершения обучения НС готова к использованию. В результате обучения НС будет вычислять выходные сигналы, близкие к эталонным данным, при соответствующих входных сигналах. При промежуточных входных сигналах сеть аппроксимирует необходимые выходные величины.

|

|

|

В данной работе изучаются алгоритмы обучения НС прямого распространения. Более точно, рассматриваются специальные архитектуры таких сетей: персептрон Розенблатта, линейная нейронная сеть и нейронная сеть прямого распространения с одним скрытым слоем. Выбор обусловлен следующими их особенностями:

- относительно просты в реализации;

- изученностью алгоритмов обучения для них;

- возможностью использования для решения реальных прикладных задач управления.

Краткие теоретические сведения

Персептрон Розенблатта

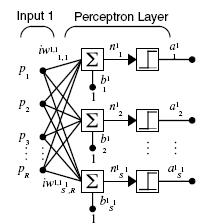

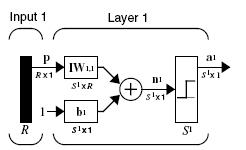

Представляет собой специальный случай (один из наиболее простых) нейронных сетей прямого распространения. Это однослойная сеть, включающая  нейронов, выходы которой принимают одно из двух значений 0 или 1. На рис.1,2 показана архитектура персептрона. Здесь и далее используются стандартные обозначения пакета MATLAB Neural Network Toolbox.

нейронов, выходы которой принимают одно из двух значений 0 или 1. На рис.1,2 показана архитектура персептрона. Здесь и далее используются стандартные обозначения пакета MATLAB Neural Network Toolbox.

|

|

|

Рис.1. Персептрон Розенблатта. Скалярная форма представления

Рис.2. Персептрон Розенблатта. Векторно-матричная форма представления

Персептрон может быть использован при решении задач классификации объектов. Для обучения используется итерационный on-line алгоритм Хебба (функция adapt в пакете MATLAB). В этом алгоритме веса НС меняются после обработки каждого обучающего вектора. Показано, что если классы линейно разделимы, то он сходится из любого начального приближения за конечное число шагов. Кроме алгоритма Хебба можно использовать off-line алгоритм (функцию train) – веса корректируются только после обработки всей обучающей выборки. В отличие от алгоритма Хебба в этом случае сходимость не гарантируются. Возможности использования в задачах классификации ограничены требованием линейной разделимости классов, которое не выполняется для многих практических задач.

Линейная нейронная сеть

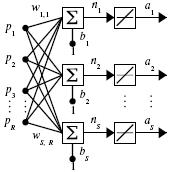

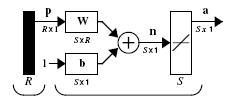

Как и персептрон представляет собой специальный случай (один из наиболее простых) нейронных сетей прямого распространения. Это однослойная сеть, включающая  нейронов, но выходы, которых, в отличие от персептрона, являются линейными комбинациями выходов нейронов. На рис.3,4 показана архитектура линейной НС.

нейронов, но выходы, которых, в отличие от персептрона, являются линейными комбинациями выходов нейронов. На рис.3,4 показана архитектура линейной НС.

|

|

|

Рис. 3. Линейная НС. Скалярная форма представления

Рис. 4. Линейная НС. Векторно-матричная форма представления

Линейная НС может быть использована при решении задач классификации объектов. Для обучения используется итерационный on-line алгоритм Уидроу-Хоффа. Возможности практического использования в задачах классификации ограничены требованием линейной разделимости классов.

Нейронная сеть прямого распространения

С одним скрытым слоем

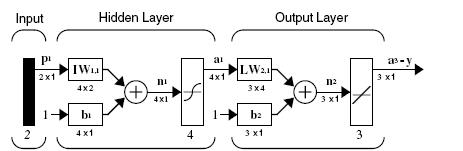

НС прямого распространения с одним скрытым слоем (рис.5) используются наиболее часто в приложениях. Основная причина состоит в том, что такая модель способна моделировать очень сложные функциональные зависимости. В частности, при решении задач классификации не требуется линейная разделимость классов.

Рис.5. НС с одним скрытым слоем

Весовые матрицы  НС являются настраиваемыми параметрами, которые определяются по обучающей выборке

НС являются настраиваемыми параметрами, которые определяются по обучающей выборке  в процессе обучения. Алгоритм обучения основан на минимизации среднеквадратической ошибки

в процессе обучения. Алгоритм обучения основан на минимизации среднеквадратической ошибки

,

,

где  - скалярный выход НС. Существует большое количество алгоритмов обучения, но наиболее распространенным является алгоритм обратного распространения ошибки и различные его модификации.

- скалярный выход НС. Существует большое количество алгоритмов обучения, но наиболее распространенным является алгоритм обратного распространения ошибки и различные его модификации.

Дата добавления: 2023-01-08; просмотров: 32; Мы поможем в написании вашей работы! |

Мы поможем в написании ваших работ!