Методы восстановления регрессии

МИНИСТЕРСТВО НАУКИ И ВЫСШЕГО ОБРАЗОВАНИЯ РОССИЙСКОЙ ФЕДЕРАЦИИ

ФЕДЕРАЛЬНОЕ ГОСУДАРСТВЕННОЕ АВТОНОМНОЕ ОБРАЗОВАТЕЛЬНОЕ УЧРЕЖДЕНИЕ ВЫСШЕГО ОБРАЗОВАНИЯ

«СЕВАСТОПОЛЬСКИЙ ГОСУДАРСТВЕННЫЙ УНИВЕРСИТЕТ»

Кафедра «Психология»

Контрольная работа

Учебный предмет: Качественные и количественные методы исследования в психологии

Работу выполнил(а)

Студент:Марасин Денис

Курс (группа): П/м-20-1о

Севастополь, 2020г.

Содержание:

1. Определение и цель множественного регрессионного анализа…………………………………....………………………3

2. Цели регрессионного анализа…………………………………..4

3. Задачи регрессионного анализа………………………………....5

4. Этапы……………………………………………………………...6

5. Методы восстановления регрессии.…………………………………………………………..7

6. Список литературы……………………………………………….9

Регрессионный анализ

Регрессио́нный анализ — набор статистических методов исследования влияния одной или нескольких независимых переменных на зависимую переменную. Независимые переменные иначе называют регрессорами или предикторами, а зависимые переменные — критериальными. Терминология зависимых и независимых переменных отражает лишь математическую зависимость переменных, а не причинно-следственные отношения. Наиболее распространенный вид регрессионного анализа — линейная регрессия, когда находят линейную функцию, которая, согласно определённым математическим критериям, наиболее соответствует данным. Например, в методе наименьших квадратов вычисляется прямая(или гиперплоскость), сумма квадратов между которой и данными минимальна.

|

|

|

Большие возможности для психологов открывает метод регрессионного анализа. Он позволяет исследовать влияние одной или нескольких зависимых переменных на независимую переменную. Предпосылка для применения регрессионного анализа — наличие связи между переменными.

Регрессионный анализ выявляет степень детерминированности зависимой (критериальной) переменной от независимых переменных (предикторов, или регрессоров) и определяет вклад каждой независимой переменной в вариацию зависимой. С помощью регрессионного уравнения можно по заданному значению предикторов рассчитать наиболее вероятное значение критериальной переменной, иными словами, регрессионный анализ открывает возможность прогноза.

График регрессии может иметь любой вид (парабола, гипербола, синус и др.), но в психологии пока в основном используется линейная регрессия. Это самый простой случай регрессионных уравнений, характеризующий линейную связь между переменными.

|

|

|

В настоящее время методы регрессиного анализа составляют сложную специальную область математической статистики.

Цели регрессионного анализа

1.Определение степени детерминированности вариации критериальной (зависимой) переменной предикторами (независимыми переменными)

2.Предсказание значения зависимой переменной с помощью независимой(-ых)

3.Определение вклада отдельных независимых переменных в вариацию зависимой

Задачи регрессионного анализа

а) Установление формы зависимости. Относительно характера и формы зависимости между явлениями, различают положительную линейную и нелинейную и отрицательную линейную и нелинейную регрессию.

б) Определение функции регрессии в виде математического уравнения того или иного типа и установление влияния объясняющих переменных на зависимую переменную.

в) Оценка неизвестных значений зависимой переменной. С помощью функции регрессии можно воспроизвести значения зависимой переменной внутри интервала заданных значений объясняющих переменных (т. е. решить задачу интерполяции) или оценить течение процесса вне заданного интервала (т. е. решить задачу экстраполяции). Результат представляет собой оценку значения зависимой переменной.

|

|

|

Парная регрессия - уравнение связи двух переменных у и х: y=f(x), где y - зависимая переменная (результативный признак); x - независимая, объясняющая переменная (признак-фактор).

Основные этапы регрессионного анализа

Выделяют следующий обобщенный многоэтапный подход к регрессионному анализу:

1. Формулировка задачи. На этом этапе формируются предварительные гипотезы о зависимости исследуемых явлений.

2. Определение зависимых и независимых (объясняющих) переменных.

3. Сбор статистических данных. Данные должны быть собраны для каждой из переменных, включенных в регрессионную модель.

4. Формулировка гипотезы о форме связи (простая или множественная, линейная или нелинейная).

5. Определение функции регрессии (заключается в расчете численных значений параметров уравнения регрессии).

6. Оценка точности регрессионного анализа.

7. Интерпретация полученных результатов. Полученные результаты регрессионного анализа сравниваются с предварительными гипотезами. Оцениваются корректность и правдоподобие полученных результатов.

|

|

|

8. Предсказание неизвестных значений зависимой переменной.

Методы восстановления регрессии

Существует целый ряд методов восстановления регрессии. Примерами таких методов являются непараметрическая регрессия с ядерным сглаживанием, линейная и нелинейная регрессия, опорные векторы, регрессионные деревья решений, многомерные адаптивные регрессионные сплайны (англ. Multivariate Adaptive Regression Splines, MARS), мультилинейная интерполяция (англ. Multilinear Interpolation), радиальные базисные функции (англ. Radial Basis Functions), робастная регрессия (англ. Robust Regression), каскадная корреляция (англ. Cascade Correlation) и многие другие способы и подходы. Детали каждого из этих подходов могут быть найдены в специальной литературе.

Вместе с тем большинство исследуемых на практике зависимостей можег быть аппроксимировано стандартными нелинейными математическими функциями, для построения которых широко используют метод наименьших квадратов (МНК). Его суть заключается в следующем.

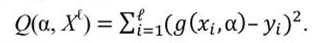

Пусть задана модель регрессии - параметрическое семейство функций g(x, а), где а ^ Rp - вектор параметров модели. Определим функционал качества аппроксимации целевой зависимости на выборке А’* как сумму квадратов ошибок:

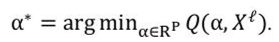

Обучение МНК состоит в том, чтобы найти вектор параметров а*, при котором достигается минимум среднего квадрата ошибки на заданной обучающей выборке Л*:

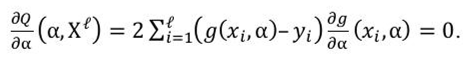

Стандартный способ решения этой оптимизационной задачи - воспользоваться необходимым условием минимума. Если функция g(x, а) достаточное число раз дифференцируема по а, то в точке минимума выполняется система р уравнений относительно р неизвестных

Решение системы таких уравнений (методами Гаусса или Крамера) позволяет найти необходимые коэффициенты а в уравнении регрессии.

Список литературы

Дрейпер Н., Смит Г. Прикладной регрессионный анализ. Множественная регрессия = Applied Regression Analysis. — 3-е изд. — М.: «Диалектика», 2007. — 912 с. — ISBN 0-471-17082-8.

Фёрстер Э., Рёнц Б. Методы корреляционного и регрессионного анализа = Methoden der Korrelation - und Regressiolynsanalyse. — М.: Финансы и статистика, 1981. — 302 с.

Захаров С. И., Холмская А. Г. Повышение эффективности обработки сигналов вибрации и шума при испытаниях механизмов // Вестник машиностроения : журнал. — М.: Машиностроение, 2001. — № 10. — С. 31—32. — ISSN 0042-4633.

Радченко С. Г. Устойчивые методы оценивания статистических моделей. — К.: ПП «Санспарель», 2005. — 504 с. — ISBN 966-96574-0-7, УДК: 519.237.5:515.126.2, ББК 22.172+22.152.

Радченко С. Г. Методология регрессионного анализа. — К.: «Корнийчук», 2011. — 376 с

Дата добавления: 2021-02-10; просмотров: 144; Мы поможем в написании вашей работы! |

Мы поможем в написании ваших работ!