Количество информации, передаваемой по каналу связи. Взаимная информация и ее свойства

ДИСКРЕТНЫЕ КАНАЛЫ С ШУМАМИ

Модель канала связи, в котором действуют шумы

Ввиду наличия шумов в канале передачи информации нарушается соответствие между переданными и принятыми сообщениями. Чем выше уровень шумов, тем сильнее нарушается это соответствие. Наиболее интересные и важные результаты теории информации были получены при рассмотрении передачи информации по каналам связи с шумами. В этом случае безызбыточное кодирование приведет к безвозвратным потерям информации: искаженный символ нельзя ни обнаружить, ни исправить. Для борьбы с влиянием помех необходимо ввести избыточность в сигнал. Основываясь на интуитивных соображениях (например, на опыте многократного повторения), легко прийти к выводу, что при неограниченном повышении требований к малости вероятности ошибки избыточность при любом способе кодирования должна неограниченно возрастать, а скорость передачи – стремиться к нулю. Здесь мы имеем яркий пример того, как сильно интуиция может привести к заблуждению. Шэннон показал, что существуют такие способы введения избыточности, при которых обеспечиваются одновременно и сколь угодно малая вероятность ошибки, и конечная (отличная от нуля) скорость передачи информации, причем эта скорость может быть сколь угодно близкой к пропускной способности канала.

Воздействие различного рода помех и собственных шумов (в общем случае будем говорить о шумах) на всякий реальный канал связи приводит к искажению передаваемых сигналов, в результате чего, получив сигнал на приемной стороне, мы не можем с полной достоверностью утверждать, какое сообщение было передано, ибо искажение сигнала шумами может привести к тому, что при передаче сообщения xiна приемной стороне будет зарегистрировано некоторое другое сообщение xj,где jне совпадает с i.

|

|

|

Пусть, например, множество возможных значений входного сигнала дискретного канала, образующие внешний алфавит системы, равно X = {xi , ..., хт}. Обозначим алфавит адресата (множество возможных значений принимаемого сигнала) через Y = {y1, у2, ..., ym}.Существует взаимно однозначное и известное адресату отображение j: X ® Y,такое, например, как показано на рис. 8.1а.

Рис. 8.1. Передача сигналов по дискретному каналу

При отсутствии помех в канале связи ошибок не происходит, что позволяет по принятому символу yi точно (безошибочно) восстановить символ xi . Действие помех разрушает однозначность отображения j. Переданный символ xi в принципе при наличии помех может быть принят в виде любого символа алфавита Y (рис. 8.1б). В то же время если получен символ yi,то достоверно это означает лишь тот факт, что был передан один из возможных символов алфавита X (рис. 8.1в).

|

|

|

Если нам известны априорные статистические характеристики источника сообщений, а также характеристики помех, воздействующих на канал, то, получив сообщение, мы можем лишь узнать новое апостериорное распределение вероятности передачи различных сообщений), с помощью которого можно вычислить вероятность правильного решения о том, какое из возможных сообщений было передано. Таким образом, работа информационного канала с математической точки зрения, в конечном счете, сводится к изменению на приемной стороне распределения вероятностей передачи различных сообщений.

Ясно, что на практике мы не можем довольствоваться лишь вычислением апостериорного распределения, а аппаратура всегда строится таким образом, что в ней с тем или иным риском (вероятностью ошибки) принимается решение о том, какое сообщение было передано.

В схеме рис. 7.1 в случае воздействия помех нет однозначного соответствия между сигналами на входе канала связи (у)и сигналами на его выходе ( z ). При передаче сигнала yi выходные сигналы ( z ) могут принимать различные значения в зависимости от того, каков был шум в момент приема. В общем случае сигнал z может принимать непрерывное (бесконечно большое число) множество различных значений.

|

|

|

Для ослабления действия шумов в информационную систему вводят два дополнительных устройства— кодер II и декодер I (рис. 8.2). Назначение второго кодера состоит в реализации помехоустойчивого кодирования сигналов.

Рис. 8.2. Блок-схема дискретного канала связи с шумами

Назначение декодера I состоит в том, чтобы восстанавливать по принятому сигналу соответствующий сигнал на выходе кодера I.

Функции, выполняемые кодером I и декодером II, такие же, как в схеме на рис. 7.1.

Рассмотрим передачу дискретных сообщений по каналу с шумом более подробно. Для этого воспользуемся представлением сигналов в линейном пространстве. Ранее была определена математическая модель сигнала в виде абстрактного математического пространства (пространства сигналов).

Естественно, что в пространстве сигнала точек должно быть не меньше, чем возможных сообщений источника информации. При равенстве числа точек и числа возможных сообщений между элементами пространства сигналов и элементами множества возможных сообщений устанавливается одно из возможных взаимно однозначных соответствий – некоторое отображение множества возможных сообщений в пространство сигнала. Это отображение реализуется в передатчике системы связи в форме соответствующего» правила преобразования сообщения в сигнал. Сигналы, представляемые в пространствах, число элементов которых равно числу возможных сообщений, обладают низкой устойчивостью к помехам.

|

|

|

Для повышения помехоустойчивости процесса передачи информации в системах связи используют сигналы с большим числом состояний, чем это необходимо для кодирования всех возможных сообщений, и, следовательно, число точек соответствующих пространств превышает число возможных сообщений. Тогда возникает вопрос: какие точки пространства сигнала сопоставлять возможным сообщениям источника информации?

На данный вопрос нельзя ответить однозначно. Ответ зависит от многих факторов: от статистических свойств потока сообщений, соотношения энергетических характеристик сигнала и помехи, статистических свойств помехи и др. Тем не менее имеются некоторые общие предпосылки.

Кодер вносит в сигналы избыточность, увеличивая длительность кодовых слов.

Число возможных последовательностей сразу резко увеличивается, но избыточность и состоит в том, что к отправке предназначаются не все из них, а лишь разрешенные. Число всевозможных последовательностей длины п равно 2 nH ( X ) , а число разрешенных к отправке равно 2пН < 2пН(X)(считаем, что энтропия исчисляется в битах); Н –энтропия на символ во множестве разрешенных к отправке последовательностей («энтропия источника», или «скорость создания информации») , Н(Х)–энтропия на символ во множестве всевозможных последовательностей. В результате воздействия шумов какие-то из символов отправленной последовательности подменяются другими и на приемный конец поступает другая, отличная от отправленной, последовательность. Поскольку р(х\у)считается известным, каждой принятой последовательности соответствует 2nH(X | Y)возможно отправленных.

Декодирование (т.е. принятие решения о том, какая последовательность была отправлена) можно выразить как разбиение всего множества Y принимаемых последовательностей на 2nH подмножеств, сопоставляемых с разрешенными к отправке: если, например, принят сигнал i-й группы, то считается, что был послан i-й разрешенный сигнал, который тут же выдается в «чистом» виде получателю.

Рассмотрим вопрос о введении избыточности вторым кодирующим устройством на примере равномерного кода.

Пусть на выходе кодера I появляются двоичные кодовые слова одинаковой длины μ, соответствующие передаваемым сообщениям. Чтобы декодер I имел возможность обнаруживать и исправлять ошибки, 2-е кодирующее устройство по некоторому правилу добавляет μk корректирующих двоичных символов к каждому кодовому слову, поступающему на его вход. В результате получаются кодовые слова длиной μ + μk символов, которые затем передаются по линии связи с шумами, где некоторые символы искажаются (символ «1» подменяется символом «0», а символ «0» – символом «1»).

При этом число различных передаваемых кодовых слов меньше числа всех возможных кодовых слов, получаемых на выходе линии связи, т. е.

, (8.1)

, (8.1)

где т – число различных кодовых символов,

N различных передаваемых кодовых слов ,это разрешенные слова, a N0 – N кодовых слов – запрещенные. Если в результате ошибок переданное (разрешенное) кодовое слово перейдет в одно из запрещенных, ошибка будет обнаружена декодером I при условии, что в его запоминающем устройстве хранятся все разрешенные кодовые слова. Если же в результате ошибок переданная комбинация превращается в одну из разрешенных, ошибка декодером I не обнаруживается.

Таким образом, корректирующий код, удовлетворяющий условию (8.1), способен в N(N0 – N ) случаях обнаруживать ошибки из общего числа N0N . Однако если N << N0, разрешенные комбинации могут быть выбраны с учетом вероятностных свойств шума так, чтобы вероятность получения ошибочной разрешенной комбинации была очень мала. Другими словами, при N << N0 в результате ошибочного приема отдельных символов принятое кодовое слово, как правило, окажется запрещенным, что и укажет на ошибку.

Для принятия однозначного решения о том, какое кодовое слово было отправлено, в общем случае все множество принимаемых кодовых слов N0разбивается по некоторому правилу на N подмножеств. Каждое подмножество отождествляется с одним из разрешенных кодовых слов. Если, например, принятое кодовое слово попало в i-е подмножество, считается, что было передано i-е кодовое слово. Задача состоит в том, чтобы выяснить, существуют ли такие правила введения корректирующих символов в передаваемые кодовые слова и разбиения на подмножества всех возможных принимаемых кодовых слов, при которых вероятность ошибочного приема будет как угодно мала, а скорость передачи как угодно близка к пропускной способности линии связи.

Эта задача в общем виде разрешается теоремами Шеннона о кодировании в присутствии шумов.

Количество информации, передаваемой по каналу связи. Взаимная информация и ее свойства

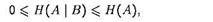

Количество информации, передаваемое по дискретному каналу связи, может быть определено через информационные характеристики ансамблей сообщений на входе и выходе канала, условные и совместные энтропии этих ансамблей. Свойства энтропии, условной энтропии кладутся в основу при введении важной теоретико-информационной характеристики канала — взаимной информации между сообщениями на его входе и выходе. Действительно, поскольку при наличии статистической связи между элементами a и b ансамбля { AB , p ( a , b )} значение условной энтропии Н(А | В) в общем случае меньше безусловной и не превосходит ее, т.е. поскольку

(8.2)

(8.2)

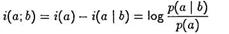

можно полагать, что наличие сведений о значении b снижает в среднем первоначальную неопределенность относительно ансамбля А. Назовем величину

(8.3)

(8.3)

количеством информации в сообщении b Î В о сообщении а Î А. (Предполагается, что в ансамбле {АВ,р(а; b )} не существует элементов с нулевыми вероятностями.)

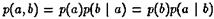

Поскольку  ,

,

то

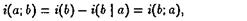

(8.4)

(8.4)

т.е. количество информации в сообщении а о сообщении b равно количеству информации в сообщении b о сообщении а. Введенное этим определением количество информации является симметрической функцией пары сообщений. Поэтому величину i(а; b) называют количеством взаимной информации между сообщениями а и b или просто взаимной информацией между этими сообщениями.

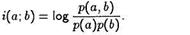

Формулам (8.3) и (8.4) можно придать симметрическую форму

(8.5)

(8.5)

Определенная таким образом взаимная информация между сообщениями a и b является случайной величиной на ансамбле АВ. Введем в рассмотрение ее математическое ожидание (см. § 5.7).

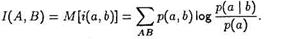

Математическое ожидание случайной величины i ( a , b ) называется средним количеством взаимной информации или просто взаимной информацией между ансамблями А и В и обознчается через 1{А, В):

(8.6)

(8.6)

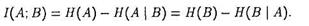

Поскольку взаимная информация между сообщениями была определена как разность собственных информации (безусловной и условной), а математическое ожидание собственной информации является по определению энтропией ансамбля, то можно записать:

(8.7)

(8.7)

Основные свойства средней взаимной информации между дискретными ансамблями. Наряду с уже отмеченным свойством симметрии I(A;В) = I (В;А), сформулируем следующие свойства, вытекающие из определения (8.6) и свойств 2 и 3 условной энтропии (см.гл. 5):

— средняя взаимная информация неотрицательна: 1(А; В) ≥ О, причем равенство имеет место тогда и только тогда, когда элементы ансамблей а Î А и b Î В статистически независимы. Доказательство этого утверждения можно провести, используя свойство (  ) натурального логарифма.

) натурального логарифма.

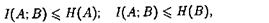

— средняя взаимная информация между ансамблями A и В не превосходит значений энтропии этих ансамблей:

(8.8)

(8.8)

причем равенства в (8.8) имеют место, когда каждому фиксированному значению а Î А с вероятностью 1 соответствует определенное значение b Î В и наоборот.

Одно из важнейших свойств средней взаимной информации заключается в том, что в процессе преобразований сигналов в различных блоках канала она не может увеличиваться [1]. Это свойство может быть истолковано следующим образом. Пусть В — множество возможных сигналов на выходе некоторого блока канала, а А — множество различных передаваемых сообщений. Доказывается, что никакая обработка наблюдаемых сигналов, при которой производится детерминированное или случайное их преобразование, не может увеличить средней информации об интересующем нас объекте. Количество информации сохраняется, если преобразование обратимо.

Дата добавления: 2019-02-26; просмотров: 747; Мы поможем в написании вашей работы! |

Мы поможем в написании ваших работ!